Investigación

¿Cómo evaluar las contribuciones de la investigación científica? Medir y jerarquizar la movilización del conocimiento en las trayectorias de postulantes a ingreso a la Carrera de Investigador Científico (CIC) en el CONICET

How to evaluate the contributions of scientific research? Measuring and hierarchizing knowledge mobilization in the trajectories of applicants to Scientific Researcher Career (CIC) at CONICET

Como avaliar as contribuições da pesquisa científica? Medir e priorizar a mobilização do conhecimento nas trajetórias dos candidatos ao ingresso na Carreira de Pesquisador Científico (CIC) do CONICET

¿Cómo evaluar las contribuciones de la investigación científica? Medir y jerarquizar la movilización del conocimiento en las trayectorias de postulantes a ingreso a la Carrera de Investigador Científico (CIC) en el CONICET

Ciencia, Docencia y Tecnología, vol. 35, núm. 70, 2024

Universidad Nacional de Entre Ríos

Recepción: 03 Abril 2023

Aprobación: 01 Febrero 2024

Resumen: En este trabajo nos enfocamos en la evaluación científica y analizamos las formas efectivas y las posibles de jerarquizar la movilización del conocimiento. Entonces, nos preguntamos: ¿cómo se miden las actividades de transferencia y/o movilización de conocimiento? y ¿qué peso tienen estas actividades sobre el total del quehacer investigativo legítimo a la hora de la evaluación? Tomando como base empírica un corpus de grillas de evaluación del Consejo de Investigaciones Científicas y Técnicas (conicet) de Argentina del año 2020 con el que fueron evaluados los candidatos a ingreso a la Carrera de Investigador Científico (cic) de cuatro comisiones de evaluación –Física, Biología, Ciencias Sociales y Desarrollo Tecnológico y Social–, el objetivo es mostrar comparativamente el peso relativo que cada comisión le asigna a las diferentes dimensiones con las que se evalúa la trayectoria científico-tecnológica de un postulante, haciendo énfasis en las formas que adopta la evaluación de la movilización del conocimiento. El trabajo muestra que el problema de la medición se presenta en dos niveles y problematiza sus implicancias: primero, el bajo peso relativo de este tipo de actividades en la evaluación global de una trayectoria y, en segundo lugar, la dificultad para poder definir qué se entiende o se reconoce como legítimo a la hora de evaluar la movilización del conocimiento.

Palabras clave: movilización del conocimiento, CONICET, evaluación CyT.

Abstract: In this paper we focus on scientific evaluation and analyze the effective and possible ways of hierarchizing knowledge mobilization. Then, we ask ourselves: How are knowledge transfer and/or mobilization activities measured, and what weight do these activities have over the total of legitimate research work at the time of evaluation? Taking as an empirical basis a corpus of evaluation grids of the Scientific and Technical Research Council (conicet) of Argentina from the year 2020 with which candidates for admission to the Scientific Researcher Career (cic) of four evaluation commissions were assessed: Physics, Biology, Social Sciences and Technological and Social Development, the objective is to show in a comparative way the relative weight that each commission assigns to the different dimensions with which the scientific-technological trajectory of an applicant is evaluated, emphasizing the forms adopted by the evaluation of knowledge mobilization. The article shows that the problem of measurement occurs at two levels and problematizes its implications: firstly, the low relative weight of this type of activities in the overall evaluation of a career and, secondly, the difficulty in defining what is understood or recognized as legitimate when evaluating the mobilization of knowledge.

Keywords: knowledge mobilization, CONICET, S&T evaluation.

Resumo: Neste trabalho focamos na avaliação científica e analisamos as formas eficazes e possíveis de priorizar a mobilização do conhecimento. Então nos perguntamos: como são medidas as atividades de transferência e/ou mobilização de conhecimento? E que peso têm estas atividades no total do trabalho investigativo legítimo no momento da avaliação? Tomando como base empírica um corpus de grades de avaliação do Conselho de Pesquisa Científica e Técnica (conicet) da Argentina do ano 2020 com as quais foram avaliados os candidatos ao ingresso na Carreira de Pesquisador Científico (cic) de quatro comissões de avaliação –Física. Biologia, Ciências Sociais e Desenvolvimento Tecnológico e Social–, o objetivo é mostrar comparativamente o peso relativo que cada comissão atribui às diferentes dimensões com que é avaliada a trajetória científico-tecnológica de um candidato, enfatizando as formas que adota na avaliação do conhecimento mobilização. O trabalho mostra que o problema da medição ocorre a dois níveis e problematiza as suas implicações: primeiro, o peso relativo baixo deste tipo de atividades na avaliação global de uma trajetória e, segundo, a dificuldade em definir o que é entendido ou reconhecido como legítimo. ao avaliar a mobilização do conhecimento.

Palavras-chave: mobilização do conhecimento, CONICET, avaliação C&T.

Introducción

La evaluación, entendida en sentido restringido, implica medir, jerarquizar –ordenar unos sobre o debajo de otros–, premiar y penalizar. Esta forma de comprender la evaluación responde a un modelo de certificación, exclusión e inclusión de lo correcto e incorrecto, así como a emitir señales a los agentes sometidos a ellas acerca de los modelos deseables de realizar las tareas encomendadas.

El reduccionismo que implica esta acepción del término «evaluación» se refleja en un modelo más o menos tipificado que es la grilla. La flexibilidad o la rigidez de los criterios de evaluación marcan una mayor o menor confianza en la autonomía de quienes ejercen la función de evaluación. El régimen de evaluación en los ámbitos de ciencia y técnica (en la academia en general) es la revisión de pares: son pares investigadores los que llevan adelante la tarea de evaluar procesos, productos y trayectorias. No existen «escuelas de evaluadores» es la propia práctica –junto con la informal sugerencia de colegas– del ejercicio, como la experiencia de haber estado sometido al sistema de evaluación la que nos entrena para ejercer el rol.

Por ahora las grillas rigen y homogeneizan las culturas evaluativas (Beigel, 2017) con una mayor o menor amplitud para complementar las mismas con aseveraciones cualitativas.

Aunque se ha generalizado la importancia otorgada a la contribución de la ciencia a la solución de problemas sociales, en la práctica pocas veces esta relevancia se presenta en forma de criterio explícito en estas grillas y en los apartados en los que quien evalúa puede hacer referencia valorativa a la misma.

Por ello en este trabajo proponemos analizar las formas efectivas y las posibles de jerarquizar (no como forma de establecer quiénes están arriba o debajo de otros, sino como modo de otorgar jerarquía/valoración a un aspecto usualmente relegado) la movilización del conocimiento, es decir, la forma en que este es efectivamente puesto en acción, usado y/o apropiado por la sociedad.

Dinámicas de movilización de conocimiento en la práctica científico-tecnológica

Las actividades que implican la movilización del conocimiento se manifiestan en tres tiempos (Naidorf y Alonso, 2018): el primero corresponde a la definición de agendas a través de la cual podemos analizar para quién, qué y cómo se elige un tema de investigación y las múltiples influencias que lo determinan. El segundo tiempo corresponde a las evaluaciones y las señales que estas emiten en tanto su carácter es performativo de futuras prácticas. El tercero procura la comprensión y las definiciones de las múltiples formas que asumen y los sentidos atribuidos a las dinámicas de apropiación y uso social del conocimiento.

En otros trabajos hemos problematizado los modos de producción de conocimiento (Alonso, 2021; Naidorf et al., 2021; Alonso et al., 2022) haciendo foco en las prácticas de los investigadores y las actividades más significativas que hacen al quehacer investigativo. Una primera lectura posible puede hacerse partiendo del locus en que se desarrollan esas tareas: actividades de investigación «intra» muros (del laboratorio, el instituto de investigación y de la propia universidad) y actividades «extra» muros que implican el trabajo en terreno, en vinculación con agentes extraacadémicos que forman parte y se incorporan e interactúan con investigadores en el primero, segundo o tercer tiempo de la movilización del conocimiento. Esta separación no necesariamente divide la práctica académica en compartimentos estancos, disociados entre sí, sino que permite poner el acento en aspectos emergentes que devienen en significativos a la hora de mirar outcomes y/o outputs (Sarewitz, 2016) de la práctica académica. De modo esquemático, podría sostenerse que el output por excelencia de esa actividad «intra» muro es la publicación académica (papers, libros, capítulos de libro, etc.) mientras que sobre los outputs que dan cuenta de la actividad «extra» muros tenemos menos certezas o, al menos, menor claridad sobre cuáles de los posibles resultados de esos procesos son reconocidos como legítimos y, por tanto, o por ello, la jerarquización de los resultados de investigación vinculados a esta dimensión deviene en problemática.

Las actividades de vinculación social y de interacción con agentes sociales resultan menos valoradas en la práctica. Esta complejidad tiene al menos dos dimensiones sobre las que indagamos en este trabajo. En primer lugar, la falta de consenso sobre qué tipo de prácticas y productos están contenidos bajo ese paraguas y, en segundo lugar, la falta de estandarización de los parámetros específicos que aparecen en las grillas de evaluación, en ocasiones por el desprecio a este tipo de actividades basado en el cuestionamiento de su naturaleza: muchas veces no consideradas estrictamente científicas.

El primer aspecto del problema es que en las actividades que se ubican bajo las denominaciones «actividades de transferencia», «desarrollos tecnológicos» o «actividades de extensión» aparecen una multiplicidad de prácticas y productos. Más allá de la ausencia de una definición taxativa –y producto también de los múltiples sentidos construidos respecto de su posible definición–, son aquellas que se proponen, de manera explícita, que el conocimiento producido por la CyT contribuya al contexto social en el que esta se encuentra y, lo que suele resultar observable en algún tipo de vínculo específico con su entorno. A lo largo de la historia, esta función social de la ciencia y la tecnología (Polanyi, 1958) ha sido nombrada de múltiples formas y los distintos modelos o visiones de la CyT (en términos de su lugar en la sociedad) dieron diferentes respuestas y denominaciones al vínculo de las universidades con las sociedades: extensión, transferencia, misión o función, compromiso social, impacto social, vinculación, etc.

El surgimiento del término «transferencia de conocimiento» puede atribuirse a la corriente de estudios sobre economía de innovación que se ocupa de rastrear las capacidades de desarrollo y adopción de tecnologías en firmas que datan de comienzos del siglo xx (Lundvall, 1988) referidos al estudio de la relación y la comunicación inter e intra-empresas con unidades de i+d e investigadores científico-tecnológicos (Clark y Fujimoto, 1991).

No resultó, entonces, para nada casual que –gracias al renovado interés en estas actividades– se haya igualado, o puesto en disputa, esa función social de la cyt (en el sentido de su potencial de contribución) a la idea de transferencia de conocimiento estrictamente referida a la lógica de la vinculación universidad-empresa con fines de comercialización: fue producto de este modelo conceptual que se consolidaron los primeros intentos de gestión y gobernanza de la cyt.

En particular, en los años 80, derivado de las decisiones gubernamentales de no acompañar con aumento del financiamiento público la expansión del sistema científico y universitario, la transferencia asociada a la noción de vinculación universidad-empresa adoptó un carácter particular en tanto solución alternativa de financiamiento (autofinanciamiento o formas complementarias de inversión denominada «recursos propios»).

La transferencia de conocimiento cobró entonces un nuevo lugar en la agenda de los estudios sociales de la ciencia, la tecnología y la universidad. El desarrollo de este campo de estudios redundó en una multiplicidad de sentidos atribuidos a la noción de transferencia de conocimiento, en primer lugar, para luego comenzar a distanciarse del concepto de transferencia e incorporar nuevas definiciones.

La noción de transferencia más extendida en la literatura reconoce el proceso de investigación, transferencia y uso de conocimientos científico-tecnológicos con el paradigma del modelo lineal de innovación consolidado durante la segunda posguerra siguiendo el esquema expuesto por Vannevar Bush en su célebre texto. En esta concepción, el conocimiento fluye de manera lineal desde la investigación científica básica (respetando la autonomía de las instituciones de educación superior) a la investigación aplicada, luego al desarrollo tecnológico, para finalizar en el mercado en forma de productos.

En cualquier caso, estas formulaciones sobre la forma que puede adoptar esa relación ciencia-sociedad, que asumimos polisémicas –según el contexto en el cual las encontremos como también opuestas en sus sentidos o con acentos puestos en aspectos diversos–, dan cuenta de una misma función que contrasta o explicita aquello que se espera de la ciencia y la tecnología como instituciones de la vida social.

Algunos ejemplos sobre esa esa naturaleza polisémica pueden encontrarse en las diferentes caracterizaciones que han sido desarrolladas por el propio campo de estudios sociales de la cyt. Solo por recuperar algunos significativos, mencionamos el de la Unidad de Investigación de Política Científica (spru, por sus siglas en inglés) de la Universidad de Sussex del Reino Unido, que define estas actividades como aquellas que «se refieren a la generación, uso, aplicación y explotación de conocimiento y otras capacidades de la universidad fuera del ambiente académico» (spru, 2002, p. 3). Otras varían desde descripciones muy laxas como «vínculos ciencia-sociedad» (Sánchez-Barrioluengo, 2014, p. 176) hasta caracterizaciones complejas que incluyen «todas las actividades que incluyan producción, comunicación, difusión o transmisión de conocimiento hacia el entorno» (Molas-Gallart y Castro-Martínez, 2007, p. 321); o «actividades relacionadas con la investigación (transferencia de tecnología e innovación), educación (formación docente) y vinculación con la sociedad (visitas a museos, conciertos, conferencias, trabajos de voluntariado, consultoría, etc.)» (E3M Project, 2012, p. 6).

En nuestra región, el interés por revisitar la contribución del conocimiento científico-tecnológico a la sociedad en su conjunto tiene larga data: desde la tradición de la extensión universitaria (Cano Menoni, 2017; Erreguerena, 2020), pasando por los aportes de la Escuela Latinoamericana de Pensamiento en Ciencia, Tecnología y Desarrollo –que problematizó las relaciones entre investigación científica y proyecto nacional de la mano de Oscar Varsavsky, Jorge Sábato, Amílcar Herrera, Natalio Botana, Máximo Halty, entre otros–, hasta trabajos recientes que revisitan la propia idea de transferencia clásica como transferencia social (Llomovatte et al., 2016), la vinculación universidad-entorno (Romero et al., 2015), la utilidad social en los procesos de producción de conocimiento (Vaccarezza y Zabala, 2002) o la producción de conocimiento orientado a fines de uso (Alonso, 2021).

Es precisamente en nuestra región –y en Argentina en particular– donde se conformó desde hace algo más de una década un «clima de ideas» (Alonso, 2021) con el que se buscó promover un vínculo más estrecho entre la producción de conocimiento del complejo de cyt y el desarrollo económico y social (Alzugaray et al., 2011; Casas, 2012; Dagnino et al., 2012; Dutrénit y Sutz, 2013; Thomas, 2008; Vessuri, 2012). Esto es, que la contribución de la ciencia de la tecnología al desarrollo nacional se vuelva autoevidente. Con ese objetivo, desde ámbitos de gestión de la cyt proliferaron múltiples instrumentos de política científica y universitaria hacia agendas y temas prioritarios y/o estratégicos (Rovelli, 2017).

Lo que está en el fondo de la cuestión es cómo promover la apropiación del conocimiento por fuera del ámbito estrictamente científico-tecnológico. De esta dimensión nodal, nos interesa y nos ocupamos en este trabajo de cómo son estas dinámicas evaluadas, ya que, siguiendo a Zeballos et al. (2021), los criterios de evaluación, como toda arquitectura de incentivos, emiten señales hacia quienes desarrollan la producción de conocimiento, por lo que es esperable que esas señales impacten sobre la dirección de la investigación y sobre la conformación de agendas (Bianco, Gras y Sutz, 2014). Por cierto, entonces, los criterios de evaluación pueden desalentar ciertos tipos de producción de conocimiento (Gras, 2018) y, a la vez, incidir en el despliegue de determinadas prácticas de investigación, para ajustarse a sus requerimientos. Si bien la evaluación es un –o el– aspecto significativo para su desarrollo, es también un mecanismo de control y modelación de las prácticas de la comunidad científica (Zeballos, Robaina, Goñi, Bianco y Waiter, 2021).

La evaluación en CyT: sentidos y desafíos

Los procedimientos de evaluación forman parte de la estructura social y política de la ciencia al ocupar una posición estratégica entre dos pilares esenciales de los sistemas de cyt: el Estado y las comunidades científicas (Zuckerman y Merton, 1971). Desde el punto de vista de la política científica, la evaluación define una forma de gobierno en lo referido a las reglas de funcionamiento y a la asignación de recursos. Tiene, por tanto, dos funciones básicas: es un instrumento de organización y gestión, a la vez que un instrumento distributivo (Fernández Esquinas et al., 2011).

La literatura internacional establece que los organismos públicos con competencias de cyt se dotan de dispositivos que les permiten obtener información relevante para la toma de decisiones. Cuando las políticas públicas asignan recursos para investigación requieren herramientas de valoración prospectiva con las que sea posible decidir entre distintas alternativas. En numerosas ocasiones, las alternativas provienen de propuestas realizadas por investigadores, por lo que las evaluaciones resultan imprescindibles para adaptar la financiación a las directrices de política científica, además de para obtener indicadores de la capacidad o calidad de los investigadores.

Desde el punto de vista de la configuración social de ciencia, las actividades de evaluación presentan una especial importancia debido a que contribuyen a establecer el conjunto de normas que rigen la actividad científica, además de influir de manera determinante en la producción científica y tecnológica. Esto es debido a que las agencias evaluadoras se constituyen como los organismos de intermediación entre los investigadores –los actores que poseen el conocimiento especializado–, y la administración pública –la organización que dispone de recursos financieros y capacidad regulativa– (Guston, 2000). En efecto, las prácticas de evaluación se extienden y asimilan como pautas habituales de comportamiento por las personas que trabajan en el ámbito de la cyt (Whitley, 2007). La evaluación es uno de los procesos que conectan los resultados de la tarea científica con el estatus de los investigadores, resultando en el mecanismo que otorga legitimidad para la obtención de recursos, así como para el progreso profesional y el acceso a determinados cargos o a esferas estratégicas de decisión. Los procedimientos de evaluación, por tanto, además de tener un componente técnico, forman parte de la estructura social de los sistemas de cyt. Es necesario conocer las diversas herramientas y los procesos sociales que generan para aprehender la compleja red de relaciones causales entre los diferentes niveles de cualquier sistema de investigación. En suma, reconocer el carácter performativo de los procesos de evaluación es imprescindible para conocer cómo se configura el gobierno de la ciencia y, al mismo tiempo, cómo se organiza la práctica científica.

Siguiendo a Fernández Esquinas et al. (2011), cuando las prácticas de evaluación se institucionalizan como el conjunto de condiciones que regulan las interacciones de una institución con la comunidad científica, es posible considerarlas como un «régimen de evaluación» (Fernández Esquinas et al., 2011). El concepto de régimen de evaluación implica una forma de gobierno de la ciencia que basa su legitimidad en los juicios emitidos por investigadores expertos y organizaciones especializadas, que establecen criterios de relevancia y capacidad para acceder a recursos económicos, puestos de trabajo, etc.

Existe aún una dificultad institucional respecto a la evaluación efectiva de algunos de los componentes de la interacción entre ciencia y sociedad de doble vía. En la práctica los investigadores involucrados en proyectos centrados en la resolución de un problema específico cumplen con una tarea que no es ponderada en la evaluación. La literatura especializada en lo que respecta a la relación evaluación y orientación de la investigación (Aksnes y Rip, 2009; De Rijcke et al., 2016; Kaltenbrunner, 2017) coincide en sostener que los investigadores no pueden considerarse como receptores pasivos, sino que juegan un rol activo en los contextos de evaluación del que a su vez participan generalmente repitiendo modelos y fórmulas. En efecto, los regímenes de evaluación, en especial los que involucran la asignación de recursos y la promoción o ascenso en trayectorias individuales, siguiendo a De Rijcke et al. (2016), tienden a producir y reproducir comportamientos en los investigadores, enfocados a reordenar las prácticas respecto a la selección de temas de investigación hacia safe zones, con las que se evitan tópicos de investigación y prácticas desconocidas en materia de resultados esperables y obtenibles.

Como mostramos más adelante, el mayor desafío en la revisión de la evaluación suele ser la débil relevancia de la evaluación de resultados que pueden otorgar las organizaciones e instituciones y la casi nula consecuencia de la misma, lo que dificulta las estrategias de acción colectiva de sus miembros (Sanz-Menéndez, 2014). El papel de la evaluación y el cambio en las pautas y conductas también es un proceso lento, en el que en la práctica se reiteran formas evaluativas conocidas por lo que resulta conveniente considerar que son los propios expertos quienes encuentran dificultades en implementar nuevas formas no clásicas de ponderar las prácticas de interacción y de coproducción social.

Medir y jerarquizar actividades de «transferencia» de la investigación en CyT

Nos centramos aquí en analizar algunos de los aspectos más significativos de los dispositivos de evaluación de aquellas actividades de transferencia, en sentido amplio. Las grillas de evaluación, en tanto dispositivos, orientan, estandarizan y ordenan los procesos de evaluación de pares dentro de la comunidad académica. El análisis de las grillas, entonces, nos permite poner el foco en las regularidades del proceso de evaluación: da cuenta de los aspectos más relevantes sobre los que se pone el acento al evaluar una trayectoria de investigación (ese quehacer investigativo que problematizamos más arriba), las actividades que se reconocen como legítimas y su peso relativo en clave comparada. Nuestro interés apunta a explorar estas cuestiones haciendo foco en un elemento, como mostramos, problemático y complejo como lo es la «transferencia de conocimiento», poniendo énfasis en las prácticas, actividades y outputs o outcomes que se materializan en los dispositivos de evaluación.

En rigor, como mostramos, la naturaleza polisémica de las prácticas que se incluyen dentro de aquello que hoy se reconoce como transferencia deviene de la complejidad de estandarización de prácticas tan disímiles y que, por tanto, sostenemos, se materializa de modo más o menos laxo en las grillas de evaluación de trayectorias de investigadores.

Para tal fin, construimos un corpus de grillas de evaluación del Consejo de Investigaciones Científicas y Técnicas (conicet) de Argentina del año 2020 con el que fueron evaluados los candidatos a ingreso a la Carrera de Investigador Científico (cic) de cuatro comisiones de evaluación: Física, Biología, Ciencias Sociales y Desarrollo Tecnológico y Social.

El criterio de selección del conicet como institución para el análisis es intencional y no pretende dar cuenta de una fotografía representativa del complejo científico-tecnológico argentino, por cierto, mucho más diverso1. En rigor, el conicet como institución y su política de formación de recursos humanos sostenida ininterrumpidamente desde 2003, en particular (Emiliozzi y Unzué, 2015; Jeppensen et al, 2016), ofrece un vector de análisis sobre los dispositivos de evaluación de trayectorias científico-tecnológicas en la Argentina reciente, que impacta de manera significativa en el desarrollo de perfiles de científicos y tecnólogos.

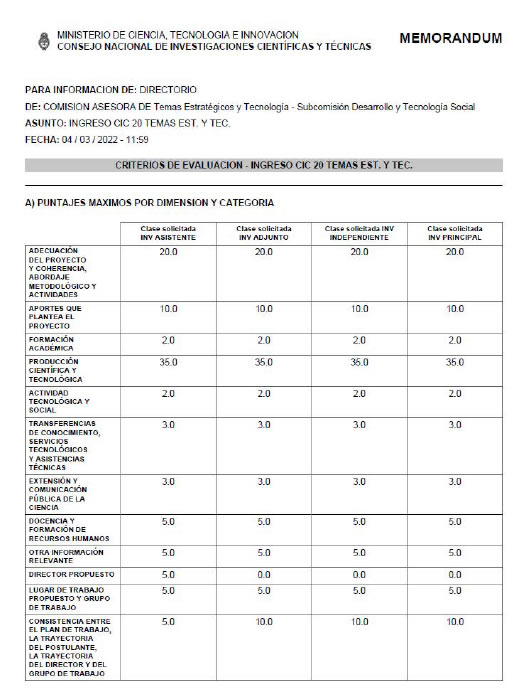

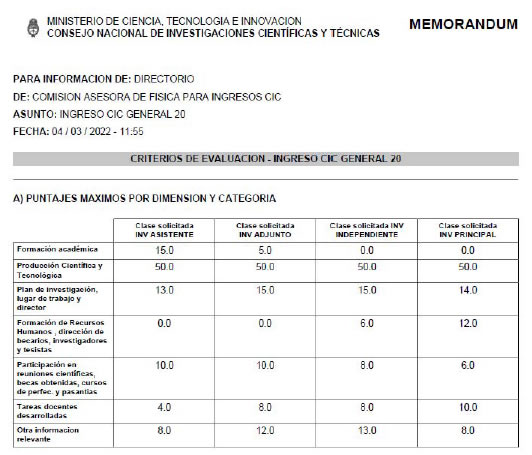

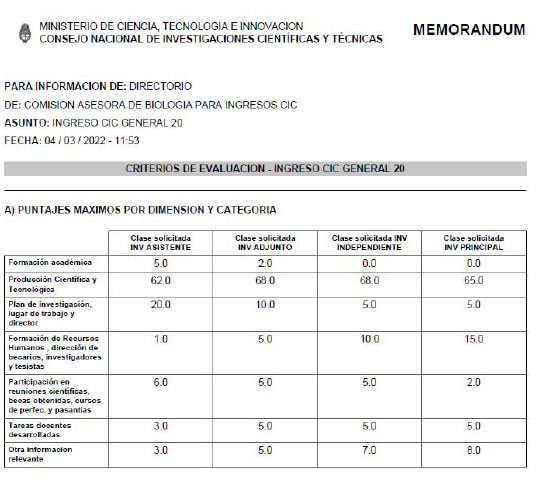

Por pedido a la Gerencia de Evaluación del conicet tuvimos acceso a los memorándums en los que cada comisión volcó sus criterios, materializados en cuatro grillas de puntajes, como se muestra en el Anexo i al final del texto2.

La selección de comisiones fue intencional y la decisión de incluir la comisión de Desarrollo Tecnológico y Social respondió a que, desde su creación en 2015, es esta comisión (en palabras del propio organismo) la encargada de desarrollar criterios de evaluación para actividades y proyectos de investigación que incluya criterios adicionales a los de naturaleza bibliométrica (publicaciones científicas).

Dado que no existe una única comisión de Ciencias Sociales en el conicet, sino nueve (Arqueología y Antropología Biológica; Ciencias Antropológicas; Economía, Ciencias de la Gestión y de la Administración Pública; Filosofía; Historia y Geografía; Literatura, Lingüística y Semiótica; Psicología y Ciencias de la Educación; Sociología, Comunicación Social y Demografía; Derecho, Ciencias Políticas y Relaciones Internacionales), construimos una única grilla para ciencias sociales con la media de los valores de las nueve comisiones para cada una de las variables de cada grilla.

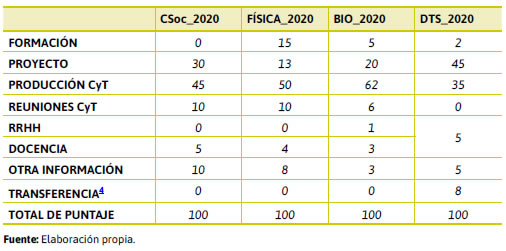

Las grillas de Física, Biología y Ciencias Sociales presentan siete variables principales:

1) Formación académica

2) Producción científica y tecnológica

3) Plan de investigación, lugar de trabajo y director

4) Formación de recursos humanos, dirección de becarios, investigadores y tesistas

5) Participación en reuniones científicas, becas obtenidas, cursos de perfeccionamiento y pasantías

6) Tareas docentes desarrolladas

7) Otra información relevante

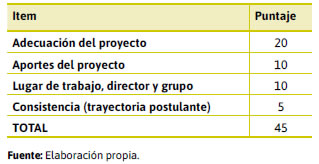

Mientras que la de Desarrollo Tecnológico y Social contiene doce variables:

1) Adecuación del proyecto y coherencia, abordaje metodológico y actividades

2) Aportes que plantea el proyecto

3) Formación académica

4) Producción científica y tecnológica

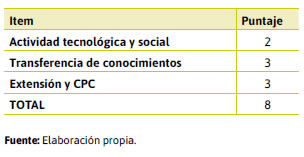

5) Actividad tecnológica y social

6) Transferencias de conocimiento, servicios tecnológicos y asistencias técnicas

7) Extensión y comunicación pública de la ciencia

8) Docencia y formación de recursos humanos

9) Otra información relevante

10) Director propuesto

11) Lugar de trabajo propuesto y grupo de trabajo

12) Consistencia entre el plan de trabajo, la trayectoria del postulante, la trayectoria del director y del grupo de trabajo

En otro trabajo nos detuvimos en el análisis de las dimensiones y actividades incluidas en cada una de las variables y su problematización epistemológica (Naidorf y Alonso, 2022). En lo que sigue, nos centramos particularmente en analizar, de las grillas como dispositivos, los elementos vinculados a lo que, ya problematizado, se enuncia como actividades de transferencia.

Para realizar un ejercicio comparado entre comisiones, hicimos una reconfiguración entre variables, como se muestra en las tablas 2 y 3. En la Tabla 1 mostramos valores de cada variable para cada una de las comisiones analizadas3.

De la lectura de las tablas surgen algunos elementos significativos. En primer lugar, como era de esperarse, el peso de la variable vinculada a la producción científico-tecnológica es significativo, siendo de 45%, 50% y 62% para Ciencias Sociales, Física y Biología respectivamente. La evaluación de la trayectoria de un postulante para el ingreso a la carrera de investigador científico al conicet se explica en más de un 50% (en promedio) por su producción científico-tecnológica. Aunque para el caso de la comisión de Desarrollo Tecnológico y Social desciende al 35%, ese valor continúa siendo muy significativo sobre el total.

«Transferencia» no es una variable de la grilla de las comisiones CSoc, física y bio; sin embargo, dentro de «Otra información» se reconocen algunas actividades que podrían reconocerse como transferencia. En particular, de la lectura de los documentos, el aspecto que aparece con mayor peso es aquel vinculado a las actividades de divulgación o comunicación pública de la ciencia (cpc). También aparece para los casos de física y bio (con diferentes valores relativos) el reconocimiento de stan (Servicios Tecnológicos de Alto Nivel) como un ítem posible dentro de la variable «Otra información».

Dicho todo lo anterior, entonces, retomamos las preguntas: ¿cómo se miden las actividades de transferencia y movilización de conocimiento? y ¿qué peso tienen estas actividades sobre el total del quehacer investigativo legítimo a la hora de la evaluación?

Para el caso de las comisiones tradicionales, vinculadas a campos o áreas disciplinares (CSoc, física y bio) la referencia a estas actividades es profundamente marginal. Dentro del dispositivo analizado (grillas) no aparecen como una variable. Sí se incluyen actividades posibles dentro de «Otra información» y el sentido más repetido es el vinculado a la comunicación y divulgación de resultados de investigación al público general. Vale aclarar que dentro de la variable «Otra información», no son estas las únicas actividades incluidas, sino que aparecen además otras múltiples dimensiones (labor editorial en revistas científicas, tareas de gestión en ámbitos de cyt, premios, participación y/o dirección de proyectos de investigación, evaluación de tesis y participación en jurados de tesis, evaluación de trabajos en revistas, entre otros, y que estas además varían según cada comisión). En términos cuantitativos, el valor asignado a las actividades de transferencia en estas tres comisiones tiende a ser de entre el 1% al 5% según el tipo de actividad sobre el total del puntaje. Puesto blanco sobre negro: las actividades de transferencia, divulgación, extensión y/o divulgación significan en promedio no más del 5% del puntaje total en la evaluación de una trayectoria de investigación.

Como era esperable, para el caso de la comisión de Desarrollo Tecnológico y Social, por otra parte, sí aparecen tres variables vinculadas de forma explícita a actividades de transferencia de conocimiento: Actividad tecnológica y social; Transferencias de conocimiento, servicios tecnológicos y asistencias técnicas, y Extensión y comunicación pública de la ciencia. Como se muestra en los documentos que dieron origen a los Proyectos de Desarrollo Tecnológico y Social5 (de donde se deriva el nombre de esta comisión), el objetivo era promover un «nuevo perfil de investigador» ofreciendo estrategias de evaluación de proyectos y trayectorias de investigación diferenciadas y orientadas a reconocer otros productos de investigación, además de las publicaciones científicas (Naidorf, 2019, 2017).

Como mostramos en las tablas 1 y 3, el peso de estas actividades sobre el total es del 8%, lo que implica ya un aumento respecto de las comisiones tradicionales incluidas en esta muestra de análisis. Además, en rigor, recuperamos para el cálculo total de puntaje de actividades de transferencia una cuarta variable que hace referencia de forma explícita a un aspecto significativo de las actividades de transferencia, como lo es la identificación explícita de aportes (en tanto resultados) que se espera que la investigación propuesta produzca. Esta variable aparece en la grilla con un valor máximo de 10 puntos (o 10% del total del puntaje).

De este modo, para el caso de la comisión de Desarrollo Tecnológico y Social, el peso relativo de las actividades de transferencia en la evaluación de la trayectoria de un investigador es del 18% del total. Este valor es sensiblemente más significativo en comparación con el de las otras comisiones, pudiendo ser su valor relativo el triple (o más del triple) respecto de las otras tres comisiones analizadas. Sin embargo, dado que la comisión de Desarrollo Tecnológico y Social se creó (y atrae) perfiles y proyectos de transferencia de conocimiento, cabe preguntarse si la distribución de puntaje que la lectura de la grilla representa (18%) es suficiente o adecuado, siendo que el peso relativo de la producción científico-tecnológica en esta comisión es casi el doble (35%). Nos preguntamos entonces, a modo de provocación, si en la evaluación de perfiles, trayectorias y proyectos de investigación explícitamente vinculados a actividades de transferencia de conocimiento el peso relativo de estas actividades en el dispositivo de jerarquización (grilla) representa algo menos del 20%: ¿qué se mide en el 80% restante? ¿Es esta distribución de puntajes la más adecuada para este tipo de evaluaciones?

El sentido de la medición

En efecto, como vimos, el peso de estas actividades en la evaluación de la trayectoria de un postulante a ingreso cic puede considerarse marginal. Ahora bien, incluso cuando se reconoce la importancia de este tipo de actividades en una trayectoria, ¿qué es lo que se evalúa de ellas?

Según el Manual de Frascati, el interés por medir la investigación y el desarrollo experimental (i+d) surge de su potencial de contribuir de manera significativa con la prosperidad y con el crecimiento económico. Por lo tanto, se considera que los indicadores influyen y generan discusiones en torno al aporte de la ciencia al bienestar general. Dicho manual iniciado en 1963 y actualizado en su última versión de 2015 procura contribuir con la medición de los diferentes tipos de resultados (outputs y outcomes) procedentes de la i+d.

Dada la dificultad que implican tales mediciones, el denominado Manual de Frascati se propone contribuir con la construcción de microdatos de i+d, el uso de los registros vinculados y las clasificaciones que facilitan el análisis de los flujos de conocimiento. Asimismo, el manual propone cinco criterios para identificar una actividad de i+d de otra que no lo es: esta debe ser novedosa, creativa, incierta con respecto a sus resultados, sistemática y transferible y/o reproducible. Este último criterio se refiere más bien a la reproducibilidad de un proceso y resultados en tanto estos queden registrados y se destaca la referencia de los mismos al uso para otras investigaciones. En este sentido, transferencia no es la acción hacia la sociedad o destinatarios específicos sino la capacidad de ser replicable. Por su parte el manual distingue qué es y qué no es actividad de i+d. En tal caso se afirma que si bien una asesoría no es i+d, las actividades de investigación destinadas a proveer a los responsables de tomar decisiones de un conocimiento exhaustivo de los fenómenos sociales, económicos o naturales deben incluirse en la i+d.

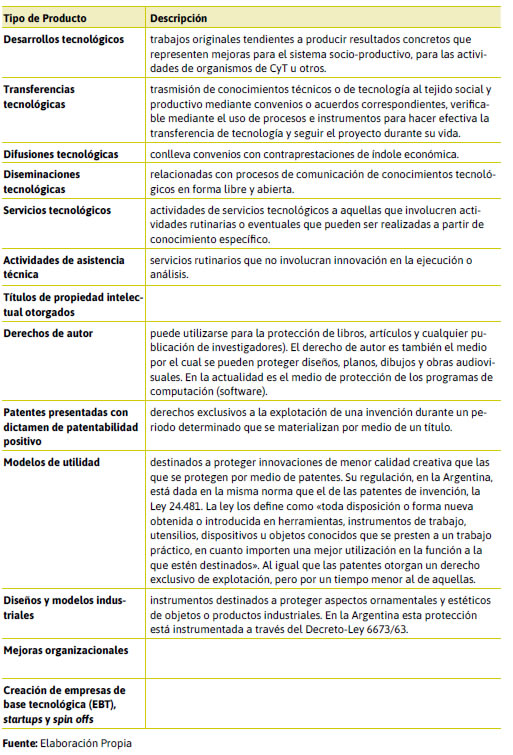

En el documento «Pautas para la evaluación de los productos y de las actividades tecnológicas» de la Gerencia de Evaluación y Planificación del conicet6 se definen una serie de actividades tecnológicas y sus productos, como se sistematiza en la Tabla 4.

No todas estas actividades corresponden con todas las disciplinas y existen diversos tipos de dificultades para que las comisiones registren, puntúen y finalmente midan las formas que la movilización del conocimiento adquiere.

En rigor, los esfuerzos por sistematizar aquello que se nos aparece como transferencia de conocimiento –nos referimos al desarrollo de indicadores de base empírica– hacen foco, casi de forma exclusiva, en la transferencia tecnológica, como bien se desprende de la Tabla 4 y del documento de base. Este sesgo se nos presenta como problemático en al menos dos aspectos: en primer lugar, porque iguala aquello con lo que se supone se mide la contribución social de la investigación a la noción restringida de tecnología7: solo es posible la transferencia de conocimiento en tanto producto tecnológico. En segundo lugar y solo analíticamente escindible de lo anterior, esa igualación invisibiliza cualquier otro output o outcome del quehacer investigativo. No solamente se restringen las actividades de movilización de conocimiento al igualarlas a alguna de las acepciones posibles de transferencia tecnológica, sino que la ausencia de criterios de medición hace que estas actividades de investigación no se presenten como legítimas a la hora de la evaluación de trayectorias y proyectos, lo que en mayor o menor medida impacta en el perfil de investigador (e investigación) que se produce y reproduce.

Una vez más, decimos entonces, que problematizar la contribución de la investigación a la sociedad que la financia y contiene no puede quedar resumida exclusivamente al relevamiento de productos tecnológicos y que la transferencia, vinculación y/o movilización del conocimiento producido por la investigación requiere de una problematización más comprensiva de parte de la comunidad académica toda en lo que refiere a identificar no solamente sus características, dinámicas y productos, sino también a los mecanismos de medición y asignación de valor a la hora de evaluar las trayectorias de investigación y los procesos de asignación de recursos. Por cierto, lo anterior también puede convertirse en insumo para desde los ámbitos de gestión de la cyt establecer prioridades y ordenar esfuerzos que permitan recorrer caminos hacia la atención a problemáticas y desafíos en nuestra sociedad.

Finalmente, es necesario también resaltar –retomando lo dicho en las secciones anteriores– que a pesar del régimen de evaluación y sus dinámicas hegemónicas, se multiplican espacios y dinámicas de producción de conocimiento que se orientan a la resolución de problemas sociales, incluso dentro del conicet, como lo son las Redes Institucionales Orientadas a la Solución de Problemas (riosp). Estas redes de investigación están destinadas a resolver problemas de gran magnitud y, basadas en el concepto problema-solución, abordan problemáticas sociales desde un punto de vista más territorial (Vicente y López Bedogni, 2022). La investigación, aquí, apunta a generar información e informes técnicos que puedan ser utilizados por tomadores de decisiones, ya sean del ámbito público o privado, y los destinatarios se convierten en socios participativos y evaluadores del producto de investigación y desarrollo en proceso. Nos preguntamos entonces: ¿con qué criterios es posible, en esta coyuntura, evaluar los productos de estas investigaciones si no se materializan en un paper?

Comentarios finales

Las intenciones manifiestas en las políticas científicas de promoción de la vinculación de la ciencia con la sociedad expresada a través de los aprendizajes mutuos que genera la interacción con agentes extraacadémicos no se condicen con el puntaje otorgado en la grilla a este tipo de actividades. Solo 2 o 3 puntos de 100 corresponden a otras actividades que atañen a la transferencia o extensión social y el corset de la alta puntuación a la producción de papers resulta todavía significativa y contraria a dichos enunciados.

Los manuales que el conicet ha elaborado son usualmente desconocidos por los evaluadores y no logran penetrar en la necesaria mutación de cultura académica más orientada a poner el foco en la movilización del conocimiento. La medición, que es solo un aspecto de la evaluación, es recuperada aquí como un tema problemático y que requiere intervenciones consensuadas pero contundentes en torno a la valoración de las distintas actividades orientadas a la producción y circulación del conocimiento.

Los programas orientados a atender el esquema problema-solución deberán tender no solo a los resultados sino al proceso de interacción como aspecto central del primer, segundo y tercer tiempo de la movilización del conocimiento.

Las grillas son un aspecto más de la evaluación, pero implican una clara emisión de señales que conviene sean atendidas si se busca deliberadamente una orientación a determinados perfiles de investigadores y cambios en las prácticas específicas de producción y diseminación del conocimiento, así como su uso y apropiación.

Referencias bibliográficas

Aksnes, D. y Rip, A. (2009). Researchers’ perceptions of citations. Research Policy, 38(6), 895-905.

Beigel, M.F.; Bekerman, F.A.; Algañaraz Soria, V.H.; Baranger, D.; Bayle, P.A.; Erreguerena, F. y Salim, R.B. (2019). Culturas evaluativas: Impactos y dilemas del Programa de Incentivos a Docentes-Investigadores en Argentina (1993-2018). Buenos Aires: CLACSO.

Clark, K. y Fujimoto, T. (1991). Heavyweight product managers. McKinsey Quarterly, (1), 42-60.

De Rijcke, S.; Wouters, P.; Rushforth, A.; Franssen, T. y Hammarfelt, B. (2016). Evaluation practices and effects of indicator use a literature review. Research Evaluation, 25(2), 161-169.

E3M-Project (2012). Needs and constraints analysis of the three dimensions of third mission activities. www.e3mproject.eu/docs/Threedim-third-mission-act.pdf

Fernández Esquinas, M.; Catalán, C. y Vielba, I. (2011). Evaluación y política científica en España: el origen y la implantación de las prácticas de evaluación científica en el sistema público de I+D (1975-1994). En T. González de la Fe y A. López Peláez (coords.), Innovación, conocimiento científico y cambio social. Ensayos de sociología ibérica de la ciencia y la tecnología (pp. 93-130). Centro de Investigaciones Sociológicas (CIS).

Guston, D. (2000). Retiring the social contract for science. Issues in Science and Technology, 16(4), 32-36.

Kaltenbrunner, W. (2017). Quantifying ‘output’ for evaluation: Administrative knowledge politics and changing epistemic cultures in Dutch law faculties. Science and Public Policy, 44(2), 284-293.

Lundvall, B. (1988). Innovation as an interactive process: from user-producer interaction to the national system of innovation. En B. Lundvall, The Learning Economy and the Economics of Hope (pp. 349-369). Anthem Press.

Molas-Gallart, J. y Castro-Martínez, E. (2007). Ambiguity and conflict in the development of ‘Third Mission’ indicators. Research Evaluation, 16(4), 321-330.

Polanyi, Michael (1958). Personal Knowledge: Towards a Post-Critical Philosophy. University of Chicago Press.

Sánchez-Barrioluengo, M. (2014). Articulating the ‘three-missions’ in Spanish universities. Research Policy, 43(10), 1760-1773.

Menéndez, L. (2014). La evaluación de la ciencia y la investigación. RES. Revista Española de Sociología, (21), 137-148.

Sarewitz, D. (2016). The pressure to publish pushes down quality. Nature, 533(7602), 147-147.

SPRU (2002). The Economic Returns to Basic Research and the Benefits of University-Industry Relationships.

Vicente, M. y López Bedogni, G. (2022). Ciencia, tecnología y demandas socio-productivas: los programas RIOSP e ImpaCT.AR. Ciencia, Tecnología y Política, 5(8), 076.

Whitley, R. (2007). Changing governance of the public sciences. En R. Whitley y J. Gläser (eds.), The Changing Governance of the Sciences (pp. 3-27). Dordrecht: Springer.

Zuckerman, H. y Merton, R. (1971). Patterns of evaluation in science: Institutionalisation, structure and functions of the referee system. Minerva, 9(1), 66-100.

ANEXO I: Memorándums del CONICET con grillas de evaluación

Notas